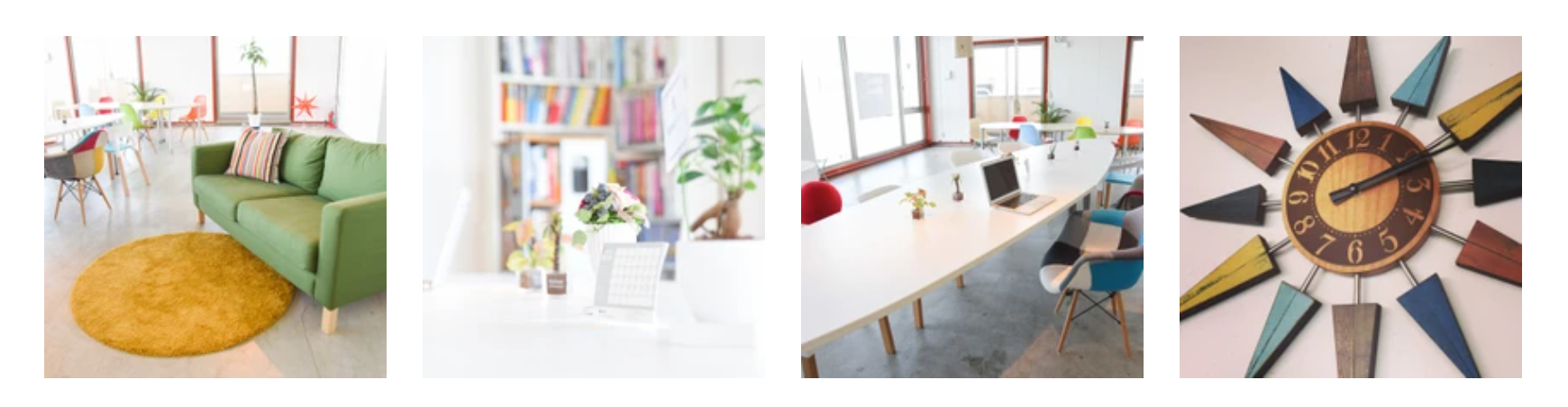

越谷市レイクタウンのコワーキングスペースHaLake

利用のご案内

事前予約は不要で、空いている席をご利用いただけます。

営業時間

- 月、火、木、金、土、日: 9:00 - 18:00

- 水曜: 定休日

※2024年6月以降は営業時間の変更を予定しており、これまでのような月額会員の方の募集を現在中止させていただいております。あらかじめご了承ください。

利用料金

2時間まで500円、一日利用は1,000円。店舗で直接お支払い下さい。予約なしに利用いただけます。

未就学児のお子さんは、ご利用いただけませんのでご了承ください。(貸し切りイベントは除きます。)また、小学生以上の方もご利用料金はかかります。

貸し切りについて

上記の営業時間外(例えば水曜日終日や、水曜日以外の18時から)であれば、貸し切りのイベント開催が可能で、時間あたり4000円で、最低二時間以上となっています。

ご相談・お問い合わせは、 info@halake.com までお願いいたします。

アクセス

JR武蔵野線、越谷レイクタウン駅の南口改札を出てすぐ左手にあるビル4Fです(イオンレイクタウンは北口のため、反対側の出口です)

同ビルの1Fの不動産「オークラホームズ」が目印

※駐車場はございませんので、予めご了承ください

〒343-0828 埼玉県越谷市レイクタウン8-11-1 レイクタウンオークラビル4F